Por RAFAEL CARDOSO SAMPAIO*

A inteligência artificial, longe de liberar tempo para a reflexão, acelera a crise produtivista na academia. Ela ameaça soterrar a boa ciência sob um dilúvio de artigos automatizados, esvaziando o conhecimento em nome de uma velocidade insustentável

1.

Vende-se a ideia, quase como um mantra, de que a Inteligência artificial fará o nosso trabalho sujo. As tarefas mais básicas, mais braçais, mais repetitivas serão delegadas aos algoritmos e, finalmente, teremos tempo para o que realmente importa: o pensamento crítico, a reflexão profunda, a criatividade.

Soa maravilhoso, não é? Mas paremos um minuto e olhemos para a história. Quando, em toda a trajetória da humanidade, a automação nos deu mais tempo livre e nos permitiu focar em atividades mais “substanciais”? A resposta é curta e grossa: nunca.

Isso jamais aconteceu. Em toda a história, quando novas tecnologias permitiram fazer mais em menos tempo, o resultado foi demissão em massa e acúmulo de trabalho para quem ficou. O que vimos, invariavelmente, foi a precarização. A promessa do tempo livre sempre se revelou uma miragem, e não há razão para acreditar que, desta vez, será diferente.

Este cenário distópico se conecta diretamente com um problema que assombra a academia há décadas: uma aceleração frenética do tempo da pesquisa. A universidade já vive sob um produtivismo desenfreado. Para medir quem produz “mais e melhor”, criamos um ecossistema de rankings, indicadores e fatores de impacto.

O jogo é simples: quanto mais um pesquisador publica, mais chances ele tem de avançar na carreira. Estudantes de pós-graduação precisam publicar para conseguir bolsas e passar em concursos; professores que publicam mais acessam financiamentos exclusivos e vantagens em editais; Programas de pós-graduação são avaliados pelo volume e qualidade das publicações, o que define seu orçamento para eventos, traduções e outras necessidades da pesquisa.

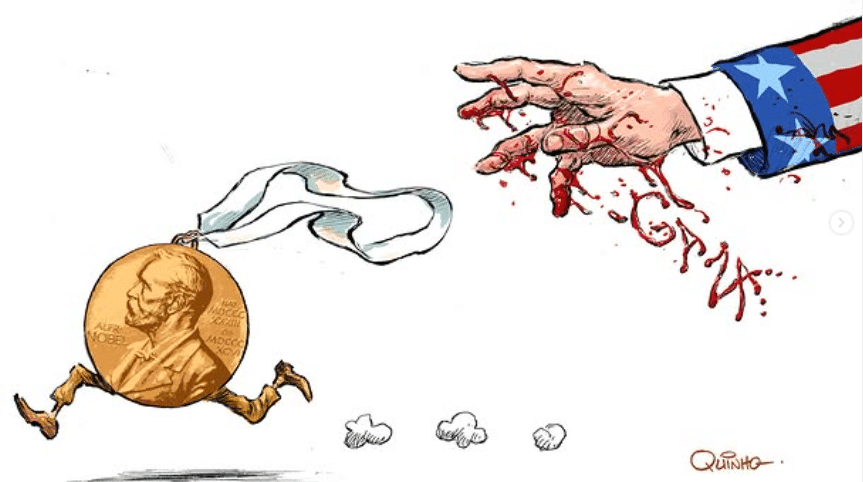

O nome disso é um velho conhecido no meio: “Publish or perish”. Publique ou morra! A academia, portanto, já opera sob a mesma lógica produtivista do capitalismo há muito tempo. A inteligência artificial generativa não criou esse monstro; ela apenas promete alimentá-lo.

Como todos já notaram, a Inteligência artificial generativa pode auxiliar em diversas etapas do trabalho acadêmico: encontrar artigos, resumir volumes massivos de texto e, claro, escrever papers inteiros. Isso nos leva a duas consequências diretas e perigosas: a facilitação da produção de lixo científico e uma aceleração ainda maior do tempo da ciência.

A primeira consequência é óbvia. A Inteligência artificial generativa permite terceirizar o pensamento.

Pense neste fluxo de trabalho, já possível hoje com ferramentas como ChatGPT e Gemini: com comandos bem detalhados, um agente de Inteligência artificial de pesquisa profunda pode vasculhar bancos de dados, selecionar os melhores artigos para a sua tarefa, resumi-los e, em seguida, gerar um relatório extenso e coerentemente organizado. Este relatório já pode vir no formato ABNT, com referências e tudo. Um artigo acadêmico tem, em média, oito mil palavras. Esses sistemas já geram relatórios com o dobro disso.

2.

E o melhor (ou pior) de tudo? Esse processo todo leva cerca de 20 minutos. Se o objetivo é apenas inflar o currículo com publicações que pareçam ciência, as portas do paraíso se abriram. Isso se conecta a outro problema crônicodas revistas predatórias. São periódicos que cobram para publicar, no esquema “pagou, levou”, sem nenhuma preocupação com rigor científico.

Nos artigos de revistas predatórias, os autores pagam taxas de processamento de artigo (APCs) relativamente baixas (média ~ US$178 por artigo) e publicações frequentemente acontecem com rapidez (2-3 meses após submissão). Como os rankings acadêmicos são, muitas vezes, automatizados, publicar lixo nessas revistas pode, sim, render pontos, citações e vantagens na carreira.

A base Cabells’ Predatory Reports ultrapassou 15.000 periódicos predatórios listados recentemente (2021), crescendo bastante desde os 4.000 verificados em 2017. Isso mostra que o universo desses periódicos continua se expandindo. Ainda, foi reportado que mais de 10.000 artigos foram retratados em 2023, um número recorde, segundo reportagens sobre fraudes científicas.

Com a Inteligência artificial, a produção de porcaria se torna tão fácil que a boa ciência corre o risco de ser soterrada. Para ser publicado em um periódico sério, um artigo precisa do aval de, no mínimo, dois pesquisadores especialistas na área. Este trabalho de revisão por pares é a base do controle de qualidade da ciência. O problema? É uma função não remunerada, ingrata e que consome um tempo precioso.

Em um mundo onde todos já estão sobrecarregados, muitos pesquisadores simplesmente pararam de dar pareceres. A equação é perversa: muitos querendo publicar, poucos dispostos a revisar. Agora, imagine essa fila, já travada, sendo inundada por artigos de baixa qualidade gerados por Inteligência artificial. O sistema pode entrar em colapso.

Essa dinâmica impõe um custo psicológico devastador aos pesquisadores. A sobrecarga de trabalho voluntário, somada à frustração de avaliar materiais de baixa qualidade, alimenta um ciclo de exaustão e desengajamento. A síndrome de burnout torna-se uma ameaça constante, enquanto a vocação para a descoberta científica é sufocada pela burocracia produtivista. O prazer da pesquisa dá lugar à ansiedade da produção, esvaziando o propósito fundamental da vida acadêmica.

3.

E isso nos leva à segunda e talvez mais profunda consequência: a ciência está perdendo o controle do seu próprio tempo. O tempo da ciência agora é o tempo do Vale do Silício. Historicamente, havia uma separação clara entre o desenvolvimento tecnológico no Vale do Silício e a pesquisa acadêmica. Os softwares que usávamos eram de empresas especializadas, com ciclos de atualização longos. Uma nova versão a cada ano, talvez a cada dois anos. Era um ritmo que podíamos acompanhar.

Agora, essa fronteira está se dissolvendo. As big Techs estão na vanguarda, investindo literalmente bilhões de dólares e desenvolvendo ferramentas que têm impacto direto e imediato na pesquisa. E o tempo delas é outro. A Inteligência artificial generativa é lançada, relançada e modificada em questão de meses. Se hoje o GPT-5, lançado há um mês, é o melhor modelo, já sabemos que no mês que vem pode surgir um Gemini 3.0, um Claude 4.5 ou um novo modelo chinês para destroná-lo.

Como cientistas, naturalmente queremos usar as melhores ferramentas, mas isso cria um paradoxo frustrante. O processo de revisão e publicação de um artigo pode facilmente levar mais de um ano. Assim, quando nossas pesquisas usando Inteligência artificial forem finalmente publicadas, os sistemas utilizados já estarão obsoletos. Ler um artigo recém-publicado trará uma sensação de arqueologia instantânea:

“Nossa, esse artigo usou o GPT-4. Se fosse o 5, os resultados certamente seriam melhores.”

O mesmo vale para dissertações e teses. No dia da defesa, o trabalho já estará tecnicamente ultrapassado. E mesmo que um pesquisador tente refazer seus experimentos com o modelo mais novo, até o momento da publicação, ele já terá sido superado novamente. Essa nova e rápida aceleração do tempo da ciência nos força a operar no ritmo das big techs, e não no ritmo necessário para a produção de conhecimento robusto e refletido.

A aceleração ditada pela lógica do Vale do Silício não afeta apenas o ritmo da pesquisa, mas também a própria cultura científica. A ciência sempre foi concebida como um empreendimento coletivo, cumulativo e duradouro, em que teorias são testadas e refinadas ao longo de anos ou décadas.

Se a meta passa a ser apenas acompanhar a última versão da Inteligência artificial disponível, corremos o risco de transformar a ciência em uma corrida de atualizações técnicas, esvaziando seu papel social como produtora de conhecimento sólido e de longo prazo. O impacto não é apenas metodológico, mas cultural: a noção de ciência como bem público pode ceder lugar a uma ciência descartável, produzida na mesma lógica de obsolescência programada que rege o mercado de aplicativos.

A inteligência artificial não é a causa da crise produtivista na academia, mas é o seu mais poderoso acelerador. Ela promete eficiência, mas entrega uma pressão por velocidade que esvazia o propósito da ciência. Corremos o risco de criar um ambiente onde a preocupação não é mais produzir bom conhecimento, mas sim usar o modelo mais recente, publicar o mais rápido possível e apenas acompanhar a corrida.

A boa ciência, por definição, demanda tempo. E tempo é o único recurso que essa nova configuração parece determinada a nos roubar. Uma saída possível seria revisar os sistemas de avaliação acadêmica, de modo a reduzir a dependência exclusiva de métricas quantitativas e valorizar mais fortemente a qualidade e a originalidade da pesquisa.

Neste sentido, precisamos levar mais a sério os movimentos, como a “Slow science” (ciência lenta), que defendem uma produção acadêmica mais ponderada e de maior qualidade, em oposição à quantidade. Outra estratégia seria fomentar iniciativas de ciência aberta e colaborativa, que diluam a pressão individual por produtividade e reforcem o caráter coletivo da produção de conhecimento.

Reconhecer que o sistema atual é insustentável é o primeiro passo para debater e construir alternativas que resgatem o verdadeiro valor da investigação científica.

*Rafael Cardoso Sampaio é professor do Departamento de Ciência Política da Universidade Federal do Paraná (UFPR).

A Terra é Redonda existe graças aos nossos leitores e apoiadores.

Ajude-nos a manter esta ideia.

C O N T R I B U A